Baxış:

Cari texnologiya landşaft, böyük məlumat və analitik insanların maraq çox alaraq iki ən mühüm sahələridir. bu dartma arxasında aydın səbəbi – müəssisələr bu böyük məlumat və BI proqram həyata iş fayda əldə. Hadoop indi əsas stream texnologiya olur, belə ki, onun əhatə dairəsi və müzakirə də texnologiya media kənarda yayılır. lakin, biz müşahidə edir – insanlar hələ də çətin faktiki anlayışları anlamaq tapmaq, və tez-tez Hadoop və digər texnologiyalar barədə bəzi qeyri-müəyyən fikir etmək.

In this article, Bizim vicdanlı səy bir çox sadə şəkildə Hadoop əsas şərtləri izah edir, belə ki, texniki və qeyri-texniki tamaşaçı bunu başa düşmək olar.

Hadoop eko-sistemi - Nə dəqiq vasitələri?

Hadoop tərəfindən idarə çox güclü açıq mənbə platformadır Apache Foundation. Hadoop platform Java texnologiyaları inşa və paylanmış salxımlı mühitdə heterogen məlumatların böyük həcmi emal etməyə qadirdir. Onun scaling qabiliyyəti paylanmış kompüter üçün mükəmməl bir seçimdir edir.

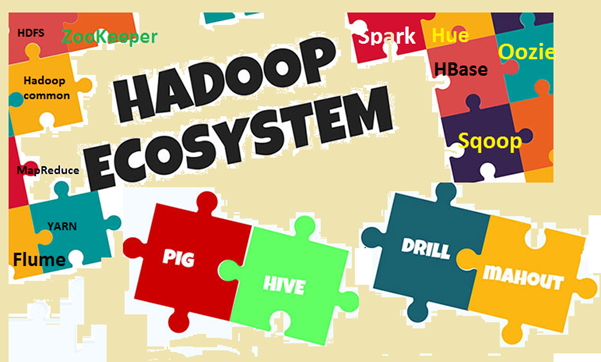

Hadoop eko-sistemi Hadoop əsas komponentləri və digər əlaqədar alətlər ibarətdir. əsas komponentləri, Hadoop Distributed File System (HDFS) və MapReduce proqramlaşdırma model iki ən mühüm anlayışlar var. əlaqədar alətləri arasında, SQL üçün Hive, Dataflow üçün Pig, və s xidmətlərin idarə edilməsi üçün Zookeeper vacibdir. Biz ətraflı bu şərtləri izah edəcək.

Image1: Hadoop eko-sistemi

əsas şərtləri bilmək lazımdır Niyə?

Biz artıq Hadoop hazırda bir çox məşhur mövzu olduğunu müzakirə etdik, və hamı onun haqqında danışır, bilərək və ya bilməyərək. Belə ki, problem- Əgər bir şey müzakirə və ya bir şey dinləmək əgər, lakin fərqində deyil nə dəqiq deməkdir, sonra nöqtələr qoşulmaq və ya onu həzm edə bilməyəcək. insanlar müxtəlif domen zaman problem daha çox görünür, iş adamları kimi, marketing uşaqlar, top idarə və s. bu insanların bilmək lazım deyil, çünki "Hadoop necə işləyir?‘, daha onlar bilmək daha maraqlıdırbu iş fayda gətirə bilər necə. iş fayda həyata keçirmək, Hadoop şərtlər anlaşma az bütün təbəqələri arasında çox vacibdir. Amma eyni zamanda, şərtlər kompleks jargons olmadan sadə şəkildə izah edilməlidir, oxucu rahat edilməsi.

əsas şərtlər anlamaq edək

Bu bölmədə müxtəlif Hadoop şərtləri və eko-sistemi tədqiq edəcək, bəzi şərh ilə. anlaşma Aydınlıq üçün, biz iki geniş kateqoriyalar edəcək, bir base modulu və digər bir Əlavə proqram paketləri və alətləri ayrı-ayrılıqda və ya Hadoop üst yüklü edilə bilər. Hadoop bütün bu şəxslərə aiddir.

First, Bizə baza modulu altında gəlir baxımından nəzər salaq.

- Apache Hadoop: Apache Hadoop bir salxımlı mühitdə məlumatların böyük həcmdə emal üçün bir açıq mənbə çərçivəsində edir. Bu etibarlı üçün sadə MapReduce proqramlaşdırma model istifadə edir, ölçeklenebilir və paylanmış hesablama. saxlanması və hesablama həm bu çərçivədə payladı.

- Hadoop ümumi: Adı təklif kimi, Müxtəlif Hadoop modulları dəstəkləmək üçün ümumi kommunal edir. Bu, əsasən ümumi alətləri və kommunal bir kitabxana. Hadoop ümumi əsasən tətbiq inkişaf zamanı developers tərəfindən istifadə olunur.

- HDFS: HDFS (Hadoop Distributed File System) paylanmış fayl sistemi əmtəə hardware arasında yayılır edir. Bu, çox sürətli tərəzi və yüksək ötürücülük təmin. Data blokları salxımlı ətraf mühitə paylanmış şəkildə təkrar və saxlanılır.

- MapReduce: MapReduce paylanmış mühitdə məlumatların böyük həcmdə paralel emal üçün proqramlaşdırma model. MapReduce Proqram iki əsas komponentdən ibarətdir, bir Map () üsul, hansı filtreleme və çeşidlənməsi həyata keçirir. digəri azaltmaq deyil () hissə, Xəritə hissəsində çıxdı xülasə yerinə yetirmək üçün nəzərdə tutulmuşdur.

- Yet Another Resource Negotiator (YARN): Bu, əsasən Hadoop mövcud resurs meneceri 2. Iplik rolu salxımlı mühitdə hesablama resurslarının idarə və cədvəli edir.

Now, Bizə Hadoop digər əlaqəli şərtləri yoxlamaq edək

- HBase: HBase bir açıq mənbə, ölçeklenebilir, paylanmış və qeyri-relational verilənlər bazası. Google-nin Java yazılı və əsaslanır Big Table. əsas storage fayl sistemi HDFS edir.

- Hive: Hive data anbar proqram, hansı oxu dəstəkləyir, paylanmış storage sistemi saxlanılan məlumatların böyük həcmdə yazılı və idarə. Bu HiveQL kimi tanınan query dil kimi SQL təmin (HQL), verilənlər bazasının querying üçün. Hive Amazon S3 və s kimi HDFS saxlama və digər uyğun fayl sistemləri dəstəkləyir.

- Apache Pig: Pig böyük data set təhlili üçün yüksək səviyyəli platforma. Pig skript yazmaq dil Donuz Latın kimi tanınır. Bu, əsasən əsas MapReduce proqramları özet və faktiki kod yazı olmadan developers MapReduce model üzərində işləmək üçün daha asan edir.

- Apache Spark: Spark (açıq mənbə) Hadoop məlumat üçün cluster hesablama çərçivə və ümumi compute mühərrik (geniş miqyaslı data-set). Demək olar ki, həyata keçirir 100 dəfə daha sürətli yaddaş MapReduce ilə müqayisədə. And, disk üçün, Bu demək olar ki, 10 sürətli dəfə. Spark bağımsız rejimi kimi müxtəlif mühitlərdə / rejimində çalıştırabilirsiniz, Hadoop on, on EC2 s. Bu HDFS məlumat əldə edə bilərsiniz, HBase, Hive və ya hər hansı digər Hadoop məlumat mənbəyi.

- Sqoop: Sqoop RDBMS və Hadoop data əsasları arasında məlumatı ötürmək üçün bir command line vasitədir. Əsasən relational və qeyri-relational verilənlər bazası arasında idxal / ixrac data üçün istifadə olunur. The name "Sqoop’ iki digər şərtlər "ilkin və son hissəsində birləşən təşkil edirSql+OlduOOP ".

- Oozie: Oozie əsasən Hadoop iş akışı mühərrik. Bu cədvəllər Hadoop iş idarə etmək üçün vəsaitlərinin iş.

- ZooKeeper: Apache ZooKeeper açıq mənbə platformadır, hansı Hadoop paylanmış uygulamalar üçün yüksək performans koordinasiya xidmət edir. Bu konfiqurasiya məlumat saxlanılması üçün mərkəzləşdirilmiş xidmət edir, adlandırma defteri, paylandı synchronization və qrup xidmətlər.

- Flume: Apache Flume paylanmış xidmət, əsasən məlumatların toplanması üçün istifadə, aqreqasiya və hərəkət. Bu log və hadisə məlumatların böyük məbləği ilə çox səmərəli işləyir.

- Hue: Hue əsasən Hadoop data analiz üçün web interfeys. Bu açıq mənbə layihədir, Hadoop və eko-sistemi dəstəkləyir. Onun əsas məqsədi daha yaxşı bir istifadəçi experience təmin etməkdir. Bu Spark üçün drag and drop obyektləri və redaktorları təmin, Hive və HBase s.

- Mahout: Mahut tez ölçeklenebilir maşın öyrənmə və data mining applications tikinti üçün açıq mənbə proqram.

- Ambari: Ambari əsasən Hadoop qruplar monitorinq və idarə olunması üçün bir web-based alətdir. Bu HDFS kimi eko-sistemi xidmətləri və alətlər üçün dəstək daxildir, MapReduce, HBase, ZooKeeper, donuz, Sqoop və s. Onun üç əsas funksiyaları ehtiyat edir, Hadoop qruplar idarə və monitorinq.

Hadoop eko-sistemi davamlı inkişaf edir, yeni proqram, xidmətləri və alətlər də ortaya çıxır. Nəticə olaraq, böyük data dünyada yeni şərtləri və jargons olacaq. Biz yaxın saat saxlamaq lazımdır və vaxt o anlamaq.

Nəticə

Bu yazıda Hadoop eko-sistemi ən mühüm əsas şərtlər müəyyən etmək üçün cəhd. Biz, həmçinin, eko-sistemi haqqında bir az müzakirə etdik və niyə biz şərtləri bilmək lazımdır. Hadoop indi əsas stream texnologiya olur, belə insanlar daha çox cəlb alır. So, Bu Hadoop dünyada istifadə olunan bəzi əsas anlayışlar və şərtlər anlamaq üçün doğru zaman. Gələcəkdə, orada yeni anlayışlar və mövcud şərtlər çox, və buna görə özümüzü yeniləmək lazımdır.