Përmbledhje:

Në peisazhin e teknologjisë aktuale, të dhënat e mëdha dhe analytics janë dy fushat më të rëndësishme, ku njerëzit janë duke marrë shumë interes. Arsyeja e qartë pas kësaj tërheqje është – ndërmarrjet janë duke marrë dobi të biznesit nga këto të dhëna të mëdha dhe aplikacionet BI. Hadoop është bërë tashmë një teknologji kryesore lumë, kështu që mbulimi dhe diskutimi i tij është gjithashtu i përhapur përtej mediave të teknologjisë. por, ajo që kemi vërejtur është – njerëz ende e kanë të vështirë të kuptojnë konceptet aktuale, dhe shpesh të bëjë disa ide të paqartë për Hadoop dhe teknologjive të tjera të lidhura.

In this article, përpjekjet tona të ndershëm është të shpjegojë kushtet kryesore Hadoop në një mënyrë shumë të thjeshtë, në mënyrë që audienca teknike dhe jo-teknike mund ta kuptojnë atë.

Hadoop eko-sistem - Çfarë saktësisht do të thotë?

Hadoop është një shumë e fuqishme platformë me kod të hapur i menaxhuar nga Fondacioni apache. Platforma Hadoop është ndërtuar mbi teknologjitë Java dhe e aftë të përpunimit volum të madh të të dhënave heterogjene në një mjedis të shpërndarë grumbulluara. aftësia e saj shkallë e bën atë një përshtatje të përsosur për informatikë shpërndarë.

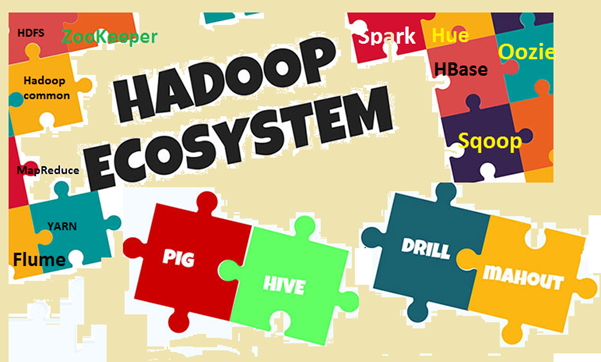

Hadoop eko-sistem përbëhet nga komponentët kryesore Hadoop dhe mjete të tjera të lidhura. Në komponentët kryesore, Hadoop Distributed File System (HDFS) dhe modeli i programimit MapReduce janë dy konceptet më të rëndësishme. Ndër mjetet e lidhura, Hive për SQL, Pig për dataflow, Zookeeper për menaxhimin e shërbimeve, etj janë të rëndësishme. Ne do të shpjegojmë këto kushte në detaje.

Image1: Hadoop eko-sistemi

Pse ju duhet të dini termat kyçe?

Ne kemi diskutuar tashmë se Hadoop është një temë shumë popullor në ditët e sotme, dhe të gjithë është duke folur në lidhje me të, dashje ose unknowingly. Pra, problemi është- nëse ju jeni duke diskutuar diçka apo dëgjuar diçka, por jo të vetëdijshëm se çfarë saktësisht do të thotë, atëherë ju nuk do të jetë në gjendje të lidhë dots ose të tretet atë. Problemi është më e dukshme kur njerëzit janë nga një domain tjetër, si njerëzit e biznesit, djema marketingut, menaxhmenti i lartë etj. Për shkak se këta njerëz nuk kanë nevojë të dini "Si funksionon Hadoop?‘, por ata janë më të interesuar të dinë se "se si ajo mund të sjellë dobi të biznesit ". Për të realizuar përfitimin e biznesit, pak e kuptimit të termave Hadoop janë shumë të rëndësishme në të gjitha shtresat. Por në të njëjtën kohë, termat duhet të shpjegohet në mënyrë të thjeshtë, pa komplekse jargons, duke e bërë lexuesit të rehatshme.

Le të kuptojmë termat kyçe

Në këtë seksion ne do të shqyrtojë kushtet e ndryshme në Hadoop dhe e eko-sistem, me disa shpjegime. Për qartësi në të kuptuarit, ne do të bëjmë dy kategori të gjera, një është e Moduli baza dhe një tjetër është paketa shtesë software dhe mjetet i cili mund të jetë i instaluar veçmas ose në majë të Hadoop. Hadoop referohet të gjitha këtyre subjekteve.

First, le të kemi një vështrim në termat e cila vjen nën modulin bazë.

- Apache Hadoop: Apache Hadoop është një kornizë me burim të hapur për përpunimin vëllim të madh të të dhënave në një mjedis grumbulli. Ai përdor të thjeshtë modelin e programimit MapReduce për të besueshme, shkallëzuar dhe shpërndarë informatikë. Ruajtja dhe llogaritjes të dyja janë shpërndarë në këtë kuadër.

- Hadoop përbashkët: Si emri sugjeron, ai përmban shërbimet e përbashkëta për të mbështetur module të ndryshme Hadoop. Kjo është në thelb një bibliotekë e mjeteve të përbashkëta dhe shërbimet. Hadoop përbashkët është përdorur kryesisht nga zhvilluesit gjatë zhvillimit të aplikimit.

- HDFS: HDFS (Hadoop Distributed File System) është një sistem i shpërndarë fotografi përfshin të gjithë hardware mall. Kjo peshore shumë të shpejtë dhe siguron xhiros të lartë. blloqe të dhënave janë të njëjta dhe të ruhen në mënyrë të shpërndarë në një mjedis grumbulli.

- MapReduce: MapReduce është një model programimi për përpunimin paralel të vëllimit të madh të të dhënave në një mjedis të shpërndarë. Programi MapReduce ka dy komponente kryesore, njëra është Map () metodë, e cila kryen filtrimin dhe zgjidhja. Një tjetër është Ulja () pjesë, projektuar për të kryer përmbledhje të prodhimit nga pjesa Harta.

- Megjithatë Një tjetër Negociatori Burimeve (fije): Kjo është në thelb një menaxher i burimeve në dispozicion në Hadoop 2. Roli i fije është për të menaxhuar dhe të planifikojë burimet informatikë në një mjedis grumbulli.

Now, le të kontrolloni kushtet e tjera të lidhura në Hadoop

- HBase: HBase është një burim të hapur, shkallëzuar, të shpërndara dhe të bazës së të dhënave jo-relacionale. Ajo është shkruar në Java dhe në bazë të Google Big Tabela. themel sistemi fotografi magazinimit është HDFS.

- Hive: Hive është software të dhënave depo, i cili mbështet lexim, shkrim dhe menaxhimin vëllim të madh të të dhënave të ruajtura në një sistem ruajtje të shpërndarë. Ajo siguron SQL si gjuhë query njohur si HiveQL (HQL), për querying dataset. Hive mbështet ruajtjen në HDFS dhe sisteme të tjera file compatible si Amazon S3 etj.

- Apache Pig: Pig është një platformë të nivelit të lartë për analiza të madhe të dhënat e vendosur. Gjuha për të shkruar Scripts Pig janë të njohur si Pig latinisht. Ajo në thelb nxjerrje programet themelore MapReduce dhe e bën më të lehtë për zhvilluesit për të punuar në modelin MapReduce pa shkruar kodin aktual.

- Apache Spark: Spark (Burim i Hapur) është një kornizë informatikë grup dhe motor të përgjithshme llogaritin për të dhënat Hadoop (në shkallë të madhe të dhënat e vëna). Ajo kryen pothuajse 100 herë më shpejt në krahasim me MapReduce në kujtesë. And, për disk, është pothuajse e 10 herë më të shpejtë. Spark mund të kandidojë në mjedise të ndryshme / mënyrë si zëvendësues vetëm mënyrë, në Hadoop, në EC2 etj. Ajo mund të shfrytëzojnë të dhënat nga HDFS, HBase, Hive apo ndonjë burim tjetër të dhënave Hadoop.

- Sqoop: Sqoop është një linjë komande mjet për transferimin e të dhënave në mes RDBMS dhe Hadoop bazave të të dhënave. Ajo është përdorur kryesisht për të dhënave të import / eksportit ndërmjet bazave të të dhënave relacionale dhe jo relacionale-. The name 'Sqoop’ është formuar duke kombinuar pjesën fillestare dhe të fundit të dy kushtet e tjera 'sql+Sikuroop '.

- Oozie: Oozie është në thelb një motor Hadoop rrjedhën e punës. Ajo oraret punojnë flukset për të menaxhuar punët Hadoop.

- ZooKeeper: Apache ZooKeeper është një platformë me kod të hapur, i cili ofron shërbimin e koordinimit të lartë të performancës për aplikimet Hadoop shpërndara. Kjo është një shërbim i centralizuar për ruajtjen e informacionit të konfigurimit, regjistrit emërtimin, shpërndarë sinkronizimi dhe grupit të shërbimeve.

- Flume: Apache Flume është një shërbim të shpërndara, përdorur kryesisht për mbledhjen e të dhënave, grumbullimi dhe lëvizja. Ai punon shumë efikase me sasi të madhe të log dhe ngjarje të dhënave.

- ngjyrë: Hue është në thelb një ndërfaqe web për analizimin e të dhënave Hadoop. Është projekt me kod të hapur, mbështet Hadoop dhe e eko-sistem. Qëllimi i tij kryesor është të sigurojë përvojë më të mirë të përdoruesit. Ajo ofron drag and drop objekteve dhe redaktorët për Spark, Hive dhe HBase etj.

- Mahout: Mahut është softuer me kod të hapur për ndërtimin e shkallëzuar të mësuarit e makinës dhe të minierave të dhënave aplikacionet shpejt.

- Ambari: Ambari në thelb është një mjet i web-it për monitorimin dhe menaxhimin e grupimeve Hadoop. Ai përfshin mbështetje për shërbimet e eko-sistemit dhe mjetet si HDFS, MapReduce, HBase, ZooKeeper, derr, Sqoop etj. tre funksioneve kryesore të saj janë të provizionit, menaxhimin dhe monitorimin vile Hadoop.

Si Hadoop eko-sistemit është vazhdimisht evoluon, software të ri, Shërbimet dhe mjetet janë gjithashtu në zhvillim. As a result, do të ketë kushte të reja dhe jargons në botën e madhe të të dhënave. Ne kemi nevojë për të mbajtur një orë të ngushtë dhe për të kuptuar ato në kohë.

Përfundim

Në këtë artikull ne jemi përpjekur për të identifikuar kushtet më të rëndësishme kyçe në eko-sistemin e Hadoop. Ne kemi diskutuar edhe pak për të ekosistemit dhe pse ne duhet të dimë kushtet. Hadoop është bërë tashmë një teknologji kryesore lumë, kështu që njerëzit janë duke marrë më shumë të përfshira në të. So, kjo është koha e duhur për të kuptuar disa koncepte themelore dhe termat e përdorur në botë Hadoop. Në të ardhmen, nuk do të shumë koncepteve dhe termave dispozicion reja, dhe ne duhet të rinovuar veten në përputhje me rrethanat.