Visión global:

No escenario da tecnoloxía actual, grandes datos e análises son as dúas áreas máis importantes en que a xente está tendo moito interese. A razón obvia por tras diso é a tracción – empresas están a recibir o beneficio da empresa fóra destes grandes datos e aplicacións de DNI. Hadoop agora é facer-se unha tecnoloxía de fluxo principal, así a súa cobertura e discusión tamén está estendendo máis aló dos medios de tecnoloxía. But, o que temos observado é – a xente aínda teñen dificultade para entender os conceptos reais, e moitas veces fan unha idea vaga no Hadoop e outras tecnoloxías relacionadas.

In this article, noso esforzo honesto é para explicar as palabras clave do Hadoop dun xeito moi sinxelo, de xeito que a audiencia técnico e non-técnico pode comprende-lo.

Hadoop eco-sistema - o que significa exactamente?

Hadoop é unha plataforma moi poderosa fonte aberto xestionado pola Fundación Apache. plataforma Hadoop é construído en tecnoloxías Java e capaz de procesar gran volume de datos heteroxéneos nun ambiente en cluster distribuído. A súa capacidade de escala fai que sexa un axuste perfecto para computación distribuída.

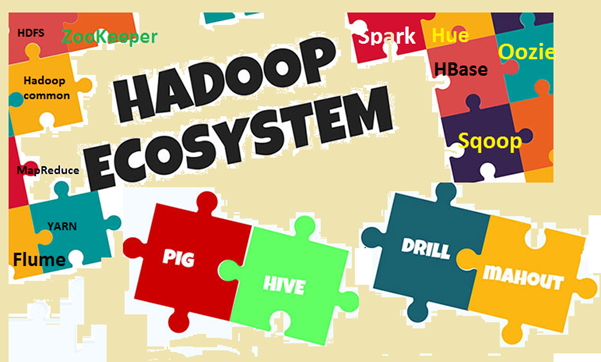

Hadoop eco-sistema consiste Hadoop compoñentes do núcleo e outras ferramentas asociadas. Nos compoñentes principais, Hadoop Distributed File System (HDFS) eo modelo de programación MapReduce son os dous conceptos máis importantes. Entre as ferramentas asociadas, Hive para SQL, Porco de fluxo de datos, Zookeeper para xestionar servizos, etc son importantes. Imos explicar estes termos detallados.

Image1: Hadoop eco-sistema

Por que ten que saber as palabras clave?

Nós xa discutir que Hadoop é un tema moi popular hoxe en día, e todo o mundo está falando sobre iso, consciente ou inconscientemente. Así, o problema é- se está discutindo algo ou escoitar algo, pero non consciente do que significa exactamente, entón non será capaz de conectar os puntos ou dixerila lo. O problema é máis visible cando a xente dun dominio diferente, como persoas de negocios, caras de marketing, xestión etc arriba. Porque estas persoas non teñen que saber 'Como Hadoop funciona?‘, ao contrario, están máis interesados en saber 'como pode traer beneficios de empresas '. Para entender o beneficio da empresa, un pouco de comprensión dos termos do Hadoop é moi importante en todas as capas. Pero, á vez, as palabras deben ser explicados de forma sinxela, sen xerga complexos, facendo que os lectores cómodo.

Imos entender os termos clave

Nesta sección iremos explorar diferentes termos en Hadoop eo seu eco-sistema, con algunha explicación. Para maior claridade na comprensión, imos facer dúas grandes categorías, unha é a módulo de base eo outro é o paquetes de software adicionais e ferramentas que se pode instalar por separado ou enriba do Hadoop. Hadoop refírese a todas estas entidades.

First, imos ter un ollar para as palabras que se atopa baixo módulo base.

- Apache Hadoop: Apache Hadoop é un framework de código aberto para o procesamento de gran volume de datos en un ambiente de cluster. Usa modelo de programación MapReduce simple para fiable, computación scalable e distribuído. O almacenamento e computación ambos son distribuídos neste cadro.

- Hadoop común: Como o nome suxire, Contén utilidades comúns para soportar diferentes módulos do Hadoop. É basicamente unha biblioteca de ferramentas e utilidades comúns. Hadoop común é usado principalmente por desenvolvedores durante o desenvolvemento de aplicacións.

- HDFS: HDFS (Hadoop Distributed File System) é un sistema de ficheiros distribuídos estende por hardware commodity. É escalas moi rápido e proporciona alto rendemento. Os bloques de datos replicados e almacenados de forma distribuída nun ambiente agrupado.

- MapReduce: MapReduce é un modelo de programación para o procesamento paralelo de gran volume de datos nun ambiente distribuído. programa MapReduce ten dúas compoñentes principais, unha é a Mapa () método, que realiza a filtración e clasificación. O outro é o Reducir () parte, deseñado para realizar resumo da saída desde a parte Mapa.

- Yet Another Resource negociador (FIO): É basicamente un xestor de recursos dispoñibles na Hadoop 2. O papel da fío é xestionar e programar recursos de computación en un ambiente de cluster.

Now, imos comprobar os outros termos relacionados en Hadoop

- HBase: HBase é unha fonte aberta, scalable, distribuídos e base de datos non-relacional. Está escrito en Java e baseadas en Google Big Table. O sistema de arquivo de almacenamento subxacente é HDFS.

- Hive: Hive é un programa de data warehouse, que soporta a lectura, escribir e xestionar gran volume de datos almacenados nun sistema de almacenamento distribuído. Ofrece SQL como linguaxe de consulta coñecido como HiveQL (HQL), para consultar o conxunto de datos. Hive soporta o almacenamento en HDFS e outros sistemas de ficheiros compatibles como Amazon S3 etc.

- Apache Pig: Pig é unha plataforma de alto nivel para a análise de conxunto de datos grande. A linguaxe para escribir scripts Pig son coñecidas como Pig Latin. Basicamente abstrai programas MapReduce subxacentes e fai máis doado para os desenvolvedores traballando no modelo MapReduce sen escribir o código real.

- Apache Spark: Spark (código aberto) é unha estrutura de computación en cluster e motor de computación xeral de datos Hadoop (Conxunto de datos a gran escala). El executa case 100 veces máis rápido en comparación con MapReduce na memoria. And, para o disco, é case 10 veces máis rápido. Faísca pode ser executado en diferentes ambientes / modo como o modo stand-alone, en Hadoop, no EC2 etc. Pode acceder a datos de HDFS, HBase, Hive ou calquera outra fonte de datos Hadoop.

- Sqoop: Sqoop é unha ferramenta de liña de comandos para transferir datos entre RDBMS e bases de datos Hadoop. É usado principalmente para os datos de importación / exportación entre bases de datos relacionais e non relacionais. nome 'Sqoop’ está formada pola combinación da parte inicial e último de dous outros termos 'sql+tivoOOP '.

- Oozie: Oozie é basicamente un motor Hadoop fluxo de traballo. El axenda o traballo flúe para xestionar tarefas do Hadoop.

- Zookeeper: Apache Zookeeper é unha plataforma de código aberto, que ofrece servizo de coordinación de alto rendemento para aplicacións Hadoop distribuídos. É un servizo centralizado para manter a información de configuración, rexistro de nomes, servizos de sincronización e de grupo distribuídos.

- canaleta: Apache Flume é un servizo distribuído, usado principalmente para a obtención de datos, agregación e movemento. Funciona de forma moi eficiente, con gran cantidade de datos de rexistro e de eventos.

- matiz: Hue é basicamente unha interface web para a análise de datos Hadoop. É proxecto de código aberto, Soporta Hadoop eo seu eco-sistema. O seu principal obxectivo é proporcionar unha mellor experiencia do usuario. Ofrece arrastrar e soltar instalacións e editores de faísca, Colmea e HBase etc.

- cornaca: Mahut é un programa de código aberto para a construción de aplicacións de aprendizaxe de máquina e minería de datos escalabades rapidamente.

- Ambari: Ambari é basicamente unha ferramenta baseada na web para supervisar e xestionar clusters Hadoop. Inclúe soporte para servizos ecossistémicos e ferramentas como HDFS, MapReduce, HBase, Zookeeper, porco, Sqoop etc. Os seus tres funcións principais son provisionais, xestión e seguimento clusters Hadoop.

Como Hadoop eco-sistema está en constante evolución, novo software, servizos e ferramentas tamén están emerxendo. Como resultado, haberá novos termos e xerga do mundo Big Data. Necesitamos seguir de preto e comprender os no tempo.

Conclusión

Neste artigo, tratamos identificar as palabras clave máis importantes no ecosistema Hadoop. Tamén discutir un pouco sobre o ecosistema e por iso que necesitamos saber os termos. Hadoop agora é facer-se unha tecnoloxía de fluxo principal, para que a xente está quedando máis implicado nel. So, é o momento para entender algúns conceptos básicos e termos utilizados no mundo Hadoop. no futuro, haberá unha morea de novos conceptos e termos dispoñibles, e debemos actualizar connosco segundo.