Oversigt:

I den nuværende teknologi landskab, store data og analyser er de to vigtigste områder, hvor folk tager stor interesse. Den indlysende årsag bag denne trækkraft er – virksomheder at få erhvervslivet fordel ud af disse store data og BI-applikationer. Hadoop er nu blevet en vigtigste stream teknologi, så dens dækning og diskussion er også breder sig ud tech medier. Men, hvad vi har observeret, er – folk stadig har svært ved at forstå den faktiske begreber, og ofte gøre nogle vag idé om Hadoop og andre relaterede teknologier.

In this article, vores ærlig indsats er at forklare de Hadoop nøglebegreber i en meget enkel måde, så teknisk og ikke-teknisk publikum kan forstå det.

Hadoop økosystem - hvad det præcis betyder?

Hadoop er en meget kraftfuld open source-platform administreres af Apache Foundation. Hadoop platform er bygget på Java-teknologier og kan behandle store mængder af heterogene data i et distribueret klyngemiljø. Dens skalering kapacitet gør det til en perfekt pasform til distribueret databehandling.

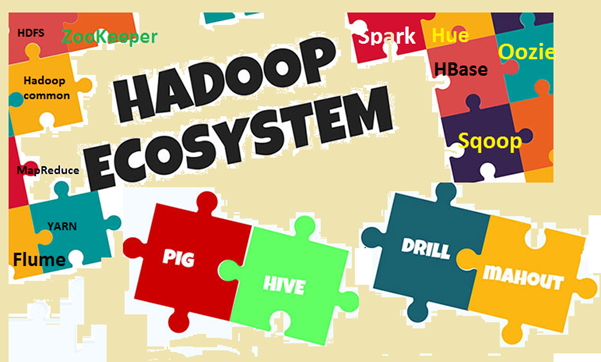

Hadoop økosystem består af Hadoop kernekomponenter og andre tilhørende værktøjer. I de centrale komponenter, Hadoop Distributed File System (HDFS) og MapReduce programmering model er de to vigtigste begreber. Blandt de tilhørende værktøjer, Hive til SQL, Pig for dataflow, Dyrepasser til styring tjenester osv er vigtige. Vi vil forklare disse begreber i detaljer.

Image1: Hadoop økosystem

Hvorfor du har brug for at kende de nøglebegreber?

Vi har allerede drøftet at Hadoop er et meget populært emne i dag, og alle taler om det, bevidst eller ubevidst. Så problemet er- hvis du diskuterer noget eller lytte til noget, men ikke klar hvad det nøjagtig midler, så vil du ikke være i stand til at forbinde prikker eller fordøje det. Problemet er mere synlig, når folk er fra et andet domæne, ligesom forretningsfolk, marketing fyre, topledelsen etc. Fordi disse mennesker ikke behøver at vide "Hvordan Hadoop fungerer?‘, de er snarere mere interesseret i at vide 'hvordan det kan bringe business fordel '. For at realisere virksomhedens fordel, en lille smule forståelse af Hadoop vilkår er meget vigtige på tværs af alle lag. Men samtidig, vilkårene skal forklares enkel måde uden komplekse jargons, gør læserne komfortable.

Lad os forstå de nøglebegreber

I dette afsnit vil vi undersøge forskellige vilkår i Hadoop og dens økosystem, med en forklaring. For klarhed i forståelsen, Vi vil gøre to brede kategorier, den ene er den bundmodul og den anden er yderligere software pakker og værktøjer der kan installeres separat eller ovenpå Hadoop. Hadoop refererer til alle disse enheder.

First, Lad os få et kig på de vilkår, der kommer under basismodul.

- Apache Hadoop: Apache Hadoop er en open-source ramme for behandling af store mængder data i et cluster miljø. Det bruger simpel MapReduce programmering model for pålidelig, skalerbar og distribueret databehandling. Opbevaring og beregning begge er fordelt i denne ramme.

- Hadoop fælles: Som navnet antyder, den indeholder fælles værktøjer til at understøtte forskellige Hadoop moduler. Det er dybest set et bibliotek af fælles værktøjer og redskaber. Hadoop fælles bruges hovedsageligt af udviklere i løbet applikationsudvikling.

- HDFS: HDFS (Hadoop Distributed File System) er et distribueret filsystem strækker sig over råvare hardware. Det skalerer meget hurtigt og giver high throughput. Datablokke replikeres og opbevares i en distribueret måde på en klyngemiljø.

- MapReduce: MapReduce er et programmeringssprog model for parallel behandling af store mængder data i et distribueret miljø. MapReduce program har to hovedkomponenter, den ene er kort () metode, som udfører filtrering og sortering. Den anden er Reducer () del, designet til at udføre resumé af output fra Map del.

- Endnu en Resource Negotiator (garn): Det er dybest set en ressource leder til rådighed i Hadoop 2. Rolle garn er at styre og planlægge computerressourcer i et cluster miljø.

Now, Lad os kontrollere de andre relaterede vilkår i Hadoop

- HBase: HBase er en open source, skalerbar, distribueret og ikke-relationel database. Det er skrevet i Java og baseret på Googles Big Table. Den underliggende storage-filsystemet er HDFS.

- Hive: Hive er data warehouse software, som understøtter læsning, skrive og administrere store mængder data, der er lagret i et distribueret lagersystem. Det giver SQL som query sprog er kendt som HiveQL (HQL), til at forespørge datasættet. Hive understøtter opbevaring i HDFS og andre kompatible filsystemer som Amazon S3 osv.

- Apache Pig: Gris er et højt niveau platform for store datasæt analyse. Det sprog, skrive Pig scripts er kendt som Pig Latin. Det dybest set abstracts de underliggende MapReduce programmer og gør det nemmere for udviklere at arbejde på MapReduce model uden at skrive selve koden.

- Apache Spark: Spark (open source) er en ramme klynge computing og generel compute motor for Hadoop data (stor skala data-sæt). Det udfører næsten 100 gange hurtigere sammenlignet med MapReduce i hukommelsen. And, til disk, det er næsten 10 gange hurtigere. Spark kan køre på forskellige miljøer / tilstand som stand-alone mode, på Hadoop, på EC2 etc. Det kan få adgang til data fra HDFS, HBase, Bistade eller andre Hadoop datakilde.

- Sqoop: Sqoop er en kommandolinje værktøj til at overføre data mellem RDBMS og Hadoop databaser. Det er hovedsageligt bruges til import / eksport data mellem relationelle og ikke-relationelle databaser. The name 'Sqoop’ dannes ved at kombinere den indledende og sidste del af to andre udtryk 'sql+havdeoop '.

- Oozie: Oozie er dybest set en Hadoop workflow motor. It tidsplaner arbejder strømme til at styre Hadoop job.

- Zookeeper: Apache Zookeeper er en open source-platform, som giver høj ydeevne koordinering service for Hadoop distribuerede applikationer. Det er en centraliseret tjeneste for at opretholde konfigurationsoplysninger, navngivning registreringsdatabasen, distribueret synkronisering og gruppe-tjenester.

- Flume: Apache Flume er en distribueret tjeneste, hovedsageligt bruges til indsamling af data, sammenlægning og bevægelse. Det virker meget effektivt med store mængder af log og event-data.

- Hue: Hue er dybest set et webinterface til analyse Hadoop data. Det er open source-projekt, understøtter Hadoop og dens økosystem. Dens vigtigste formål er at give bedre brugeroplevelse. Det giver træk og slip faciliteter og redaktører til Spark, Hive og HBase etc.

- mahout: Mahut er open source-software til opbygning skalerbare machine learning og data mining programmer hurtigt.

- Ambari: Ambari er dybest set et webbaseret værktøj til overvågning og styring af Hadoop klynger. Det omfatter støtte til økosystemtjenester og værktøjer som HDFS, MapReduce, HBase, Zookeeper, Svin, Sqoop etc. Dens tre vigtigste funktionaliteter provisioning, styring og overvågning Hadoop klynger.

Som Hadoop økosystem er konstant udvikling, ny software, tjenester og værktøjer også opstå. Som resultat, vil der være nye vilkår og jargons i big data verden. Vi er nødt til at holde et vågent øje og forstå dem i tide.

Konklusion

I denne artikel har vi forsøgt at identificere de vigtigste nøglebegreber i Hadoop økosystem. Vi har også diskuteret lidt om økosystemet, og hvorfor vi har brug for at kende de vilkår. Hadoop er nu blevet en vigtigste stream teknologi, så folk bliver mere involveret i det. So, det er det rigtige tidspunkt til at forstå nogle grundlæggende begreber og udtryk, der anvendes i Hadoop verden. I fremtiden, vil der en masse nye begreber og udtryk til rådighed, og vi skal opdatere os i overensstemmelse hermed.