Přehled:

V současné technologie krajiny, zpracování velkých objemů dat a analytické nástroje jsou dvě nejdůležitější oblasti, kde jsou lidé velký zájem užívající. Zřejmým důvodem tohoto tahu je – Podniky jsou stále užitek z těchto velkých dat a aplikace BI. Hadoop se nyní stal hlavní proud technologie, takže jeho pokrytí a diskuse se také šíří za hranice technologických médií. Ale, co jsme pozorovali je – lidé stále obtížné pochopit skutečné koncepty, a často dělají nějakou mlhavou představu o Hadoop a dalších souvisejících technologií.

In this article, Naše upřímná snaha je vysvětlit základní pojmy Hadoop ve velmi jednoduchým způsobem, takže technických a non-technické publikum může pochopit.

Hadoop ekosystému - co to přesně znamená?

Hadoop je velmi silný open source platforma řízen Apache Foundation. Hadoop platforma je postavena na technologiích Java a schopné zpracovávat obrovské množství různorodých dat v distribuovaném prostředí clusteru. Jeho schopnost škálování z ní činí perfektní fit pro distribuované výpočty.

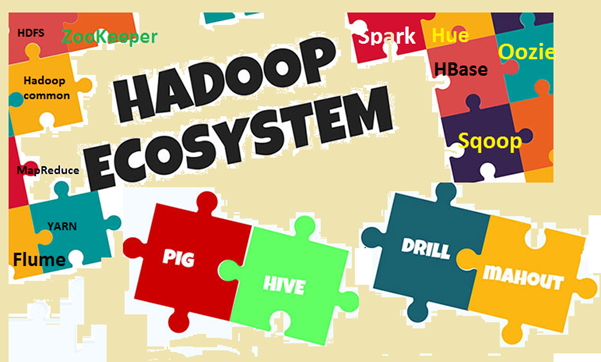

Hadoop eko-systém se skládá z Hadoop hlavních komponentů a dalších souvisejících nástrojů. V hlavních komponent, Hadoop Distributed File System (HDFS) a MapReduce programovací model jsou dva nejdůležitější pojmy. Mezi souvisejících nástrojů, Úl pro SQL, Pig pro datovým tokem, Zookeeper pro správu služby atd jsou důležité. Budeme vysvětlit tyto pojmy v detailech.

Image1: Hadoop eko-systém

Proč je třeba znát klíčové termíny?

Již jsme hovořili, že Hadoop je velmi populární téma v dnešní době, a všichni o tom mluví, vědomě či nevědomě. Takže je problém- pokud jste o něčem nebo něco poslouchal, ale neznají, co to přesně znamená, pak nebudete moci pospojovat nebo strávit ji. Problém je lépe vidět, když jsou lidé z jiné domény, jako podnikatelů, marketingové kluci, vrcholový management atd. Protože tito lidé nepotřebují vědět "Jak funguje Hadoop?‘, spíše mají větší zájem vědět "Jak to může přinést užitek ". Pro realizaci obchodní výhodu, trochu pochopení Hadoop hlediska jsou velmi důležité ve všech vrstvách. Ale zároveň, tyto podmínky by měly být vysvětleny v jednoduchým způsobem, aniž by komplexní jargons, takže čtenáři pohodlné.

Pojďme pochopit klíčové pojmy

V této části se budeme zabývat různými výrazy v Hadoop a jeho ekosystém, s nějakým vysvětlením. Jasnost v porozumění, uděláme dvě široké kategorie, jeden je Základní modul a druhý je Další softwarové balíky a nástroje které mohou být instalovány samostatně nebo v horní části Hadoop. Hadoop se vztahuje ke všem těmto subjektům.

First, pojďme se podívat na podmínky, které spadá do základního modulu.

- Apache Hadoop: Apache Hadoop je open-source framework pro zpracování velkého objemu dat v prostředí s clustery. Využívá jednoduchý MapReduce programovací model pro spolehlivé, škálovatelné a distribuované výpočetní. Skladování a výpočet jak jsou distribuovány v tomto rámci.

- Hadoop obyčejný: Jak název napovídá, obsahuje běžné nástroje pro podporu různých Hadoop modulů. Je to v podstatě knihovna běžně používaných nástrojů a pomůcek. Hadoop společné se používá hlavně vývojáři během vývoje aplikace.

- HDFS: HDFS (Hadoop Distributed File System) je distribuovaný souborový systém se klene přes komoditní hardware. To váhy velmi rychle a poskytuje vysokou propustnost. Datové bloky jsou replikovány a uloženy v distribuovaném způsobem na prostředí s clustery.

- MapReduce: MapReduce je programovací model pro paralelní zpracování velkého objemu dat v distribuovaném prostředí. MapReduce Program má dvě hlavní složky, jeden je Mapa () metoda, který provádí filtrování a třídění. Ten druhý je snížit () část, navrženy tak, aby provést shrnutí výstupu z mapy části.

- Yet Another Resource Vyjednavač (PŘÍZE): Je to v podstatě správce zdrojů k dispozici v Hadoop 2. Úlohou příze je řídit a plánovat výpočetní výkon v prostředí s clustery.

Now, pojďme zkontrolovat další související pojmy v Hadoop

- HBase: HBase je open source, škálovatelné, distribuované a non-relační databáze. Je napsán v Javě a založený na společnosti Google Big Table. Podkladové skladování souborový systém HDFS.

- Hive: Úl je datový sklad software, který podporuje čtení, psaní a správu velkého objemu dat uložených v distribuovaném systému úložiště. Poskytuje SQL jako dotazovacího jazyka známého jako HiveQL (HQL), pro dotazování datové sady. Hive podporuje ukládání v HDFS a další kompatibilní souborové systémy, jako je Amazon S3 atd.

- Apache Pig: Prase je vysoká úroveň platformou pro velké datové sady analýzy. Jazyk psát Pig skripty jsou známé jako prasečí latině. Je to v podstatě abstrahuje základní MapReduce programy a usnadňuje vývojářům pracovat na MapReduce modelu bez psaní skutečný kód.

- Apache Spark: Spark (open source) je rámec Cluster Computing a generální Compute Engine pro data Hadoop (rozsáhlá soubor údajů). Provádí téměř 100 krát rychlejší ve srovnání s MapReduce v paměti. And, na disku, to je téměř 10 krát rychlejší. Jiskra může běžet na různých prostředích / režim, jako je režim stand-alone, na Hadoop, na EC2 etc. Je možné přistupovat k datům z HDFS, HBase, Úl nebo jakýkoli jiný zdroj dat Hadoop.

- Sqoop: Sqoop je nástroj příkazové řádky pro přenos dat mezi RDBMS a databázím Hadoop. Používá se především pro import / export dat mezi relační a non-relační databáze. The name "Sqoop’ je vytvořena kombinací první a poslední část dvou dalších výrazů "sql+měloop ".

- Oozie: Oozie je v podstatě motor Hadoop work flow. rozvrhy to funguje toky řídit Hadoop pracovních míst.

- Zookeeper: Apache Zookeeper je open source platforma, který poskytuje vysoký výkon koordinační službu pro Hadoop distribuovaných aplikací. To je centralizovaný služba pro udržování informací o konfiguraci, registr pojmenování, distribuované synchronizace a skupinové služby.

- žlab: Apache žlab je distribuovaná služba, používá především pro sběr dat, agregace a pohyb. Funguje to velmi efektivně s velkým množstvím protokolu a událostí dat.

- Odstín: Hue je v podstatě webové rozhraní pro analýzu dat Hadoop. Je open source projekt, Podporuje Hadoop a její ekosystém. Jejím hlavním účelem je poskytnout lepší uživatelskou zkušenost. Poskytuje přetažení zařízení a editory pro Spark, Úl a HBase etc.

- mahout: Mahut je open source software pro rychlé vytváření škálovatelných strojového učení a dolování dat aplikací.

- Ambari: Ambari je v podstatě nástroj založený web pro sledování a řízení Hadoop clusterů. To zahrnuje podporu pro eko-systémových služeb a nástrojů, jako jsou HDFS, MapReduce, HBase, Zookeeper, Prase, Sqoop etc. Jeho tři hlavní funkce jsou zajišťování, řízení a sledování Hadoop clusterů.

Jako Hadoop ekosystému se neustále vyvíjí, nový software, služby a nástroje jsou také nově vznikající. Jako výsledek, tam budou nové podmínky a jargons ve velkém datovém světě. Musíme pečlivě sledovat a pochopit ty, které v čase.

Závěr

V tomto článku jsme se pokusili identifikovat nejdůležitější klíčové pojmy v ekosystém Hadoop. Také jsme diskutovali trochu o ekosystému, a proto musíme znát podmínky. Hadoop se nyní stal hlavní proud technologie, takže lidé jsou stále více zapojeni do něj. So, to je ten správný čas pochopit některé základní pojmy a termíny používané ve světě Hadoop. Napříště, tam bude spousta nových koncepcí a termínů k dispozici, a musíme se podle toho aktualizovat sami.