Vue d'ensemble:

Dans le paysage de la technologie actuelle, grandes données et l'analyse sont les deux domaines les plus importants où les gens prennent beaucoup d'intérêt. La raison évidente derrière cette traction est – les entreprises obtiennent des avantages commerciaux sur ces grandes données et des applications de BI. Hadoop est maintenant devenu une technologie de flux principal, donc sa couverture et la discussion se répand aussi au-delà des médias tech. Mais, ce que nous avons observé est – les gens ont encore du mal à comprendre les concepts réels, et font souvent une idée vague sur Hadoop et d'autres technologies connexes.

In this article, notre effort honnête est d'expliquer les termes clés Hadoop d'une manière très simple, de sorte que public technique et non technique peut le comprendre.

Hadoop éco-système - Ce que cela signifie exactement?

Hadoop est une plate-forme open source très puissant géré par Fondation Apache. plate-forme Hadoop est construit sur les technologies Java et capable de traiter énorme volume de données hétérogènes dans un environnement en cluster distribué. Sa capacité de mise à l'échelle permet un ajustement parfait pour le calcul distribué.

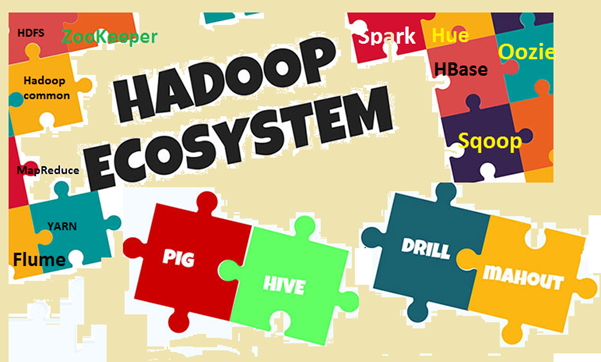

l'éco-système Hadoop se compose de Hadoop composants de base et d'autres outils associés. Dans les composants de base, Hadoop Distributed File System (HDFS) et le modèle de programmation MapReduce sont les deux concepts les plus importants. Parmi les outils associés, Hive pour SQL, Pig pour dataflow, Zookeeper pour la gestion des services, etc sont importants. Nous allons expliquer ces termes dans les détails.

Image1: éco-système Hadoop

Pourquoi vous avez besoin de connaître les termes clés?

Nous avons déjà discuté que Hadoop est un sujet très populaire de nos jours, et tout le monde en parle, consciemment ou inconsciemment. Donc, le problème est- si vous parlez de quelque chose ou écouter quelque chose, mais pas au courant de ce qu'il signifie exactement, alors vous ne serez pas en mesure de relier les points ou digérer. Le problème est plus visible lorsque les gens sont d'un domaine différent, comme les gens d'affaires, les gars de marketing, top management etc. Parce que ces gens ne doivent pas savoir 'Comment fonctionne Hadoop?‘, plutôt ils sont plus intéressés de savoir »comment elle peut apporter des avantages pour les entreprises '. Pour réaliser l'avantage de l'entreprise, un peu de compréhension des termes Hadoop sont très important dans toutes les couches. Mais en même temps, les termes doivent être expliqués de manière simple, sans jargons complexes, rendant les lecteurs confortable.

Essayons de comprendre les termes clés

Dans cette section, nous allons explorer différents termes dans Hadoop et son éco-système, avec quelques explications. Pour plus de clarté dans la compréhension, nous allons faire deux grandes catégories, on est le module de base et l'autre est le packages et outils logiciels supplémentaires qui peut être installé séparément ou sur le dessus de Hadoop. Hadoop se réfère à toutes ces entités.

First, nous avons un regard sur les conditions qui vient sous module de base.

- Apache Hadoop: Apache Hadoop est un cadre open-source pour le traitement de grand volume de données dans un environnement en cluster. Il utilise le modèle de programmation simple de MapReduce pour fiable, informatique évolutive et distribuée. Le stockage et le calcul à la fois sont distribués dans ce cadre.

- Hadoop commune: Comme son nom l'indique, il contient des utilitaires communs pour soutenir les modules Hadoop différents. Il est fondamentalement une bibliothèque d'outils communs et des services publics. Hadoop commune est principalement utilisé par les développeurs au cours du développement de l'application.

- HDFS: HDFS (Hadoop Distributed File System) est un système de fichiers distribué étend sur du matériel de base. Il évolue très rapidement et fournit un débit élevé. Les blocs de données sont répliquées et stockées de manière distribuée sur un environnement en cluster.

- MapReduce: MapReduce est un modèle de programmation pour le traitement en parallèle d'un grand volume de données dans un environnement distribué. programme de MapReduce a deux composantes principales, l'une est la carte () méthode, qui réalise le filtrage et le tri. L'autre est le Réduire () partie, conçu pour effectuer la synthèse de la sortie de la partie de la carte.

- Encore un autre négociateur de ressources (FIL): Il est essentiellement un gestionnaire de ressources disponibles dans Hadoop 2. Le rôle de YARN est de gérer et planifier les ressources informatiques dans un environnement en cluster.

Now, laissez-nous vérifier les autres termes connexes dans Hadoop

- HBase: HBase est une open source, évolutive, distribué et base de données non relationnelle. Il est écrit en Java et basé sur Google Grande table. Le système de fichiers de stockage sous-jacent est HDFS.

- Hive: Hive est un logiciel d'entrepôt de données, qui prend en charge la lecture, l'écriture et la gestion de grands volumes de données stockées dans un système de stockage distribué. Il fournit SQL comme langage de requête appelé HiveQL (HQL), pour l'interrogation de l'ensemble de données. Hive supporte le stockage dans HDFS et d'autres systèmes de fichiers compatibles comme Amazon S3 etc.

- Apache Pig: Pig est une plate-forme de haut niveau pour une grande analyse d'ensemble de données. Le langage pour écrire des scripts Pig sont connus comme Pig Latin. Il fait abstraction essentiellement les programmes MapReduce sous-jacents et le rend plus facile pour les développeurs de travailler sur le modèle de MapReduce sans écrire le code réel.

- Apache Spark: Spark (Open source) est un cadre cluster de calcul et moteur de calcul général pour les données Hadoop (ensemble de données à grande échelle). Il effectue presque 100 fois plus rapide par rapport à MapReduce en mémoire. And, pour le disque, c'est presque 10 fois plus rapide. Spark peut fonctionner sur des environnements / mode différent comme le mode stand-alone, sur Hadoop, sur EC2 etc. Il peut accéder aux données de HDFS, HBase, Hive ou toute autre source de données Hadoop.

- Sqoop: Sqoop est un outil de ligne de commande pour transférer des données entre les SGBDR et les bases de données Hadoop. Il est principalement utilisé pour les données d'import / export entre les bases de données relationnelles et non-relationnelles. The name 'Sqoop’ est formé par la combinaison de la première partie et la dernière de deux autres termes 'Sql+Avaitoop '.

- oozie: Oozie est fondamentalement un moteur de flux de travail Hadoop. Il planifie de travailler flux pour gérer les travaux Hadoop.

- ZooKeeper: Apache ZooKeeper est une plate-forme open source, qui fournit un service de coordination de haute performance pour les applications Hadoop distribués. Il est un service centralisé pour maintenir des informations de configuration, Registre de nommage, services de synchronisation et de groupes distribués.

- Buse: Apache Flume est un service distribué, principalement utilisé pour la collecte des données, l'agrégation et le mouvement. Il fonctionne très efficacement avec une grande quantité de données de journal et d'événements.

- Teinte: Hue est essentiellement une interface web pour l'analyse des données Hadoop. Il est projet open source, soutient Hadoop et son éco-système. Son objectif principal est de fournir une meilleure expérience utilisateur. Il fournit des glisser-déposer des installations et des éditeurs pour Spark, Hive et HBase etc.

- Cornac: Mahut est un logiciel open source pour construire des applications d'apprentissage machine et exploration de données évolutives rapidement.

- Ambari: Ambari est fondamentalement un outil basé sur le Web pour le suivi et la gestion des clusters Hadoop. Il inclut le support pour les services éco-système et des outils tels que HDFS, MapReduce, HBase, ZooKeeper, Porc, Sqoop etc. Ses trois principales fonctionnalités sont Provisioning, la gestion et le suivi des clusters Hadoop.

Comme l'éco-système Hadoop est en constante évolution, nouveau logiciel, services et outils font également leur apparition. As a result, il y aura de nouveaux termes et jargons dans le grand monde de données. Nous devons surveiller de près et de comprendre ceux qui dans le temps.

Conclusion

Dans cet article, nous avons essayé d'identifier les termes clés les plus importants dans l'éco-système Hadoop. Nous avons également discuté un peu plus sur l'éco-système et pourquoi nous avons besoin de connaître les termes. Hadoop est maintenant devenu une technologie de flux principal, afin que les gens sont de plus impliqués dans ce. So, il est le bon moment pour comprendre certains concepts de base et les termes utilisés dans le monde Hadoop. Dans le futur, il y aura beaucoup de nouveaux concepts et termes disponibles, et nous devons nous mettre à jour en conséquence.