Visió de conjunt:

En el panorama de la tecnologia actual, grans volums de dades i anàlisi són les dues àrees més importants on la gent està prenent molt d'interès. La raó òbvia darrere d'això és la tracció – les empreses estan rebent el benefici empresarial d'aquests grans volums de dades i aplicacions de BI. Hadoop és ara convertit en una tecnologia de corrent principal, pel que la seva cobertura i la discussió també s'està estenent més enllà dels mitjans de comunicació d'alta tecnologia. But, el que hem observat és – les persones encara els resulta difícil entendre els conceptes reals, i, sovint fer una idea vaga sobre Hadoop i altres tecnologies relacionades.

In this article, nostre esforç honest és explicar els termes clau de Hadoop d'una manera molt senzilla, de manera que l'audiència tècnica i no tècnica pot entendre.

Hadoop eco-sistema - el que significa exactament?

Hadoop és un molt potent plataforma de codi obert gestionat per Fundació Apache. plataforma Hadoop es basa en tecnologies Java i capaç de processar gran volum de dades heterogenis en un entorn en clúster distribuït. La seva capacitat d'escalat fa que sigui un ajust perfecte per a la computació distribuïda.

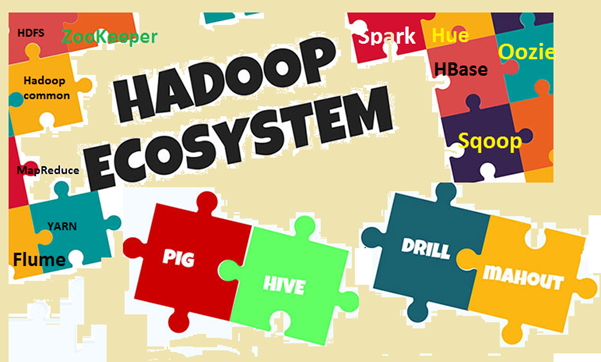

Hadoop eco-sistema consta dels components bàsics de Hadoop i altres eines associades. En els components bàsics, Hadoop Distributed File System (HDFS) i el model de programació MapReduce són els dos conceptes més importants. Entre les eines associades, Rusc per SQL, Porc de flux de dades, Zookeeper per a la gestió dels serveis, etc són importants. Anem a explicar aquests termes en els detalls.

Image1: ecosistema Hadoop

Per què vostè necessita saber els termes clau?

Ja hem discutit que Hadoop és un tema molt popular avui en dia, i tothom està parlant d'ell, conscient o inconscientment. Així que el problema és- Si vostè està discutint alguna cosa o escoltant alguna cosa, però no conscient del que significa exactament, llavors vostè no serà capaç de connectar els punts o digerir. El problema és més visible quan les persones són d'un domini diferent, de la mateixa manera que la gent de negocis, individus de la comercialització, la part superior de gestió, etc.. A causa de que aquestes persones no necessiten saber 'Com funciona Hadoop?‘, sinó que són més interessat a saber 'la forma en què pot aportar beneficis de negoci '. Per donar-se compte de l'avantatge del negoci, una mica de comprensió dels termes de Hadoop són molt importants en totes les capes. Però al mateix temps, els termes s'han d'explicar en forma senzilla i sense argots complexes, fent que els lectors còmode.

Anem a entendre els termes clau

En aquesta secció anem a explorar diferents termes en Hadoop i el seu ecosistema, amb alguna explicació. Per a més claredat en la comprensió, farem dues grans categories, una és la mòdul de base i l'altre és el paquets i eines de programari addicionals que es pot instal·lar per separat o en la part superior de Hadoop. Hadoop es refereix a totes aquestes entitats.

First, anem a fer una ullada als termes comprès en el mòdul de base.

- Apache Hadoop: Apache Hadoop és un marc de codi obert per al processament de grans volums de dades en un entorn agrupat. S'utilitza el model de programació MapReduce simple per fiable, la computació escalable i distribuït. L'emmagatzematge i computació tant es distribueixen en aquest marc.

- Hadoop comuna: Com el seu nom indica, que conté utilitats comuns per suportar diferents mòduls de Hadoop. Es tracta bàsicament d'una biblioteca d'eines i utilitats comunes. Hadoop comú és utilitzat principalment pels desenvolupadors durant el desenvolupament d'aplicacions.

- HDFS: HDFS (Hadoop Distributed File System) és un sistema d'arxius distribuït s'estén a través de maquinari de consum. Es escala molt ràpid i ofereix un alt rendiment. Els blocs de dades es repliquen i s'emmagatzemen de forma distribuïda en un entorn agrupat.

- MapReduce: MapReduce és un model de programació per al processament paral·lel de gran volum de dades en un entorn distribuït. MapReduce programa té dos components principals, un és el mapa () mètode, que realitza el filtrat i classificació. L'altre és el Reduir () part, dissenyat per realitzar resum de la sortida de la part del mapa.

- No obstant això, un altre negociador de recursos (FIL): Es tracta bàsicament d'un administrador de recursos disponibles a Hadoop 2. El paper de fil és per gestionar i programar els recursos informàtics en un entorn agrupat.

Now, anem a veure els altres termes relacionats en Hadoop

- HBase: HBase és un codi obert, escalable, distribuïda i la base de dades no relacionals. Està escrit en Java i basat en Google de taula gran. El sistema d'arxius d'emmagatzematge subjacent és HDFS.

- Hive: Rusc és un programari d'emmagatzematge de dades, que dóna suport a la lectura, l'escriptura i la gestió de gran volum de dades emmagatzemades en un sistema d'emmagatzematge distribuït. Proporciona SQL com a llenguatge de consulta conegut com HiveQL (HQL), per consultar el conjunt de dades. Rusc és compatible amb l'emmagatzematge en HDFS i altres sistemes d'arxius compatibles com Amazon S3, etc..

- Apache Pig: Porc és una plataforma d'alt nivell per a l'anàlisi conjunt de dades gran. El llenguatge per escriure scripts de porc que es coneix com llatí de porc. Bàsicament s'abstreu els programes MapReduce subjacents i fa que sigui més fàcil per als desenvolupadors treballar en el model MapReduce sense necessitat d'escriure el codi real.

- Apache Spark: Spark (codi obert) és una plataforma de computació clúster i motor de càlcul general de dades Hadoop (conjunt de dades a gran escala). Es porta a terme gairebé 100 vegades més ràpid en comparació amb MapReduce en la memòria. And, per al disc, és gairebé 10 vegades més ràpid. Espurna pot executar-se en diferents entorns / manera com manera autònoma, en Hadoop, a EC2 etc.. Es pot accedir a les dades de HDFS, HBase, Rusc o qualsevol altra font de dades Hadoop.

- Sqoop: Sqoop és una eina de línia d'ordres per a transferir dades entre RDBMS i bases de dades Hadoop. S'utilitza principalment per a les dades d'importació / exportació entre les bases de dades relacionals i no relacionals. The name 'Sqoop’ es forma mitjançant la combinació de la part inicial i últim de dos termes "quadratsl+tingutoop '.

- oozie: Oozie és bàsicament un motor de flux de treball Hadoop. la programa perquè els fluxos de treball per administrar els treballs de Hadoop.

- ZooKeeper: Apache ZooKeeper és una plataforma de codi obert, que ofereix un servei de coordinació d'alt rendiment per a aplicacions distribuïdes Hadoop. És un servei centralitzat per mantenir la informació de configuració, registre de noms, serveis de sincronització i de grup distribuïts.

- aforador: Apache Canal de flux és un servei distribuït, utilitzat principalment per a la recol·lecció de dades, l'agregació i el moviment. Funciona de manera molt eficient amb gran quantitat de dades de log i esdeveniments.

- matís: El to és bàsicament una interfície web per a l'anàlisi de dades Hadoop. És projecte de codi obert, dóna suport Hadoop i el seu ecosistema. El seu objectiu principal és proporcionar una millor experiència d'usuari. Proporciona arrossegar i deixar anar les instal·lacions i els editors de l'espurna, Rusc i HBase etc..

- cuidador d'elefants: Mahut és un programari de codi obert per a la creació d'aplicacions d'aprenentatge automàtic i mineria de dades escalables de manera ràpida.

- Ambari: Ambari és bàsicament una eina basada en web per al seguiment i la gestió de clústers Hadoop. Inclou suport per als serveis de l'ecosistema i eines com HDFS, MapReduce, HBase, ZooKeeper, porc, Sqoop etc.. Les seves tres funcions principals està aprovisionant, gestió i seguiment dels clústers Hadoop.

Com ecosistema Hadoop està en contínua evolució, nou programari, També estan sorgint serveis i eines. Com a resultat, hi haurà nous termes i argots en el gran món de les dades. Hem de mantenir una estreta vigilància i entenem els moments.

Conclusió

En aquest article hem tractat d'identificar els termes clau més importants en l'ecosistema Hadoop. També hem discutit una mica sobre l'ecosistema i per què necessitem saber els termes. Hadoop és ara convertit en una tecnologia de corrent principal, perquè les persones són cada vegada més involucrats en ella. So, és el moment adequat per entendre alguns conceptes bàsics i els termes utilitzats en el món Hadoop. En el futur, hi haurà una gran quantitat de nous conceptes i termes disponibles, i hem de actualitzar-nos en conseqüència.